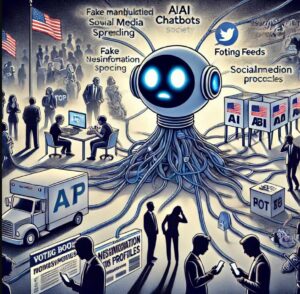

AI आणि चॅटबॉट्स, विशेषतः GPT : मतदानावर परिणाम करण्याचा धोका

AI आणि चॅटबॉट्स, विशेषतः GPT सारख्या मॉडेल्सचा लोकशाहीवर धोका अनेक पातळ्यांवर असू शकतो, कारण हे तंत्रज्ञान मोठ्या प्रमाणावर संवाद साधण्यात आणि माहिती पसरवण्यात सक्षम आहे. या धोक्यांचा लोकशाही प्रक्रियेवर आणि नागरिकांच्या निर्णयप्रक्रियेवर मोठा परिणाम होऊ शकतो:

1. चुकीची माहिती (Misinformation) आणि दिशाभूल करणारी माहिती (Disinformation):

– चुकीची माहिती पसरवणे: AI चॅटबॉट्स चुकीची माहिती सहज पसरवू शकतात. सोशल मीडियावर लोकांना चुकीचे किंवा दिशाभूल करणारे संदेश पाठवून लोकांची मते बदलू शकतात. निवडणुकीच्या काळात चुकीची माहिती किंवा अपप्रचार पसरवणे, खोटी आश्वासने देणे, विरोधकांवर आरोप करणे यामुळे मतदारांमध्ये संभ्रम निर्माण होतो.

– कृत्रिम प्रचार: AI चॅटबॉट्सचा वापर मोठ्या प्रमाणात खोट्या किंवा एकतर्फी प्रचारासाठी केला जाऊ शकतो. ज्या देशांमध्ये सोशल मीडियावर जास्त अवलंबून राहतात, तेथे अशा प्रकारे मतदानावर परिणाम करण्याचा धोका वाढतो.

2. बनावट प्रोफाइल्स आणि सोशल मीडियावर प्रभाव:

– बनावट व्यक्तिमत्व निर्माण करणे: AI तंत्रज्ञानाचा वापर करून सोशल मीडियावर मोठ्या प्रमाणात बनावट प्रोफाइल तयार केले जाऊ शकतात. हे प्रोफाइल्स एखाद्या विशिष्ट विचारसरणीचा प्रचार करू शकतात, आणि त्यातून निवडणुकीच्या प्रक्रियेत अनैतिक मार्गाने प्रभाव टाकला जाऊ शकतो.

– सामाजिक गटांमध्ये दुरावा निर्माण करणे: चॅटबॉट्सद्वारे तयार केलेली भडकाऊ माहिती सामाजिक गटांमध्ये दुरावा निर्माण करू शकते. जात, धर्म, राजकारण यासारख्या विषयांवर तीव्र मतभेद निर्माण करून समाजात द्वेषाचे वातावरण तयार होऊ शकते.

3. मतदारांच्या मनावर प्रभाव:

– AI-चालित मतदार प्रभाव: चॅटबॉट्स व्यक्तींच्या वैयक्तिक माहितीवर आधारित अत्यंत वैयक्तिकृत संदेश तयार करू शकतात. AI मतदारांच्या सोशल मीडिया व्यवहाराचे विश्लेषण करून त्यांच्या आवडीनिवडी, विचारसरणी ओळखून त्यानुसार विशिष्ट माहिती त्यांच्यापर्यंत पोहोचवू शकतो. त्यामुळे मतदार अनभिज्ञपणे त्यांच्या मतांवर परिणाम करणाऱ्या प्रचारांमध्ये अडकू शकतात.

– आवडत्या गोष्टींचा फायदा घेणे: AI अल्गोरिदम लोकांच्या आवडीनिवडी आणि भीती ओळखून त्यांना प्रभावित करू शकतो. जेव्हा मतदारांना त्यांच्या आवडत्या मुद्द्यांवर सतत माहिती दिली जाते, तेव्हा त्यांच्या राजकीय विचारांवर नकारात्मक किंवा एकतर्फी परिणाम होऊ शकतो.

4. विरोधकांच्या प्रतिमेची मोडतोड (Character Assassination):

– AI च्या माध्यमातून कोणत्याही व्यक्तीची प्रतिमा समाजात बदनाम केली जाऊ शकते. विरोधकांच्या विरोधात खोट्या बातम्या किंवा आरोप पसरवून त्यांच्या प्रतिमेला धक्का दिला जाऊ शकतो. अशा प्रचारामुळे मतदारांच्या नजरेतून ती व्यक्ती किंवा पक्ष खराब होतो.

5. लोकशाही संवादाचे व्यवधान:

– समाजातील संवादाचे तुकडे: AI-आधारित चॅटबॉट्स माहितीची चाळणी करतात आणि ती लोकांना फीड करतात. त्यामुळे लोकांना तेवढीच माहिती मिळते, जी त्यांच्या आधीच्या विचारसरणीशी जुळते. अशा परिस्थितीत लोक एकमेकांचे मुद्दे समजून घेण्याऐवजी, स्वतःच्या विचारांवरच ठाम राहतात, ज्यामुळे लोकशाही संवादाची प्रक्रिया खंडित होते.

– प्रतिसादित माहिती (Echo Chambers): AI अल्गोरिदमचा वापर लोकांना त्यांच्या आधीच्याच विचारसरणीशी संबंधित माहिती देतो. परिणामी, लोकांमध्ये विस्तृत संवाद होण्याऐवजी एकतर्फी विचार वाढतो, जो लोकशाहीसाठी अपायकारक ठरू शकतो.

6. डेटा हेरफेर आणि गोपनीयतेचा धोका:

– वैयक्तिक माहितीचा दुरुपयोग: AI आणि चॅटबॉट्स वापरकर्त्यांची वैयक्तिक माहिती गोळा करून त्याचा वापर राजकीय उद्देश साध्य करण्यासाठी करू शकतात. मतदारांची सवय, त्यांचे आर्थिक व्यवहार, वैयक्तिक आवडीनिवडी अशा माहितीचा गैरवापर करून त्यांच्यावर प्रभाव टाकला जाऊ शकतो.

– डेटा उल्लंघन: AI च्या माध्यमातून मोठ्या प्रमाणात डेटा चोरी किंवा हॅकिंग होण्याचा धोका आहे. राजकीय पक्ष किंवा सरकार विरोधकांच्या किंवा मतदारांच्या गोपनीयतेचा भंग करू शकतात.

7. मतदारांचा अविश्वास:

– एआय च्या वाढत्या हस्तक्षेपामुळे लोकशाही संस्थांवर लोकांचा विश्वास कमी होऊ शकतो. जर मतदारांना वाटले की AI तंत्रज्ञान त्यांच्या निर्णय प्रक्रियेत अवैधपणे हस्तक्षेप करत आहे, तर त्यांनी निवडणूक प्रक्रियेकडे दुर्लक्ष करणे किंवा मतदान न करणे पसंत करू शकते.

8. आगामी धोके आणि भविष्यातील प्रभाव:

– AI चे तंत्रज्ञान अधिक विकसित होत असताना, भविष्यात त्याचा लोकशाहीवर अधिक गडद प्रभाव पडू शकतो. तंत्रज्ञानाची नैतिकता आणि सुरक्षितता कशी राखायची, यावर विचार न केल्यास, तंत्रज्ञान लोकशाही प्रक्रियेला कमजोर करू शकते.

या सर्व मुद्द्यांमुळे एआय आणि चॅटबॉट्सच्या नैतिक वापराची गरज अत्यंत महत्त्वाची ठरते. नियमांचे पालन, पारदर्शकता आणि तंत्रज्ञानावर नियंत्रण ठेवण्याच्या पद्धती लोकशाहीला सुदृढ ठेवण्यासाठी आवश्यक आहेत.